Alpaca大模型是一款基于LLaMA的大语言模型,它可以模拟自然语言进行对话交互,并协助用户完成写作、翻译、编写代码、生成脚本等一系列创作任务。用户可以借助Alpaca大模型自行搭建大模型,本文就以国内云服务器商阿里云为例,为大家介绍在阿里云GPU云服务器上基于Alpaca大模型搭建个人对话大模型,仅供参考。

一、创建并配置阿里云GPU云服务器实例

阿里云是全球领先的云计算及人工智能科技公司,目前提供多种类型的产品和服务,热门产品包括日本/香港/美国云服务器、日本/美国/香港GPU云服务器、轻量应用服务器等。

阿里云GPU云服务器是提供GPU算力的弹性计算服务,具有超强的计算能力,适用于AI推理、AI训练、图形图像、科学计算多种应用场景。

阿里云GPU云服务器提供包年包月和按量付费两种计费模式可选,同时提供丰富的方案配置可选,用户可以根据需求自行选择。

阿里云GPU云服务器热门方案推荐

《点击进入官网选购》

阿里云GPU云服务器在全球范围内提供多个地区机房位置可选,根据机房位置不同分为美国云服务器、香港云服务器、中国大陆云服务器、日本云服务器、韩国云服务器、新加坡云服务器等,用户可以根据自身需求选择合适的机房位置。

1、进入阿里云官网,注册并完成登录操作。

2、在云服务器实例创建页面,创建云服务器实例。

关键参数说明如下:

- 实例规格:选择实例规格为ecs.gn7i-c16g1.4xlarge。

- 镜像:公共镜像Ubuntu 22.04,并选中安装GPU驱动,选择CUDA 版本12.1.1/Driver 版本535.154.05/CUDNN 版本8.9.7.29。

- 系统盘:不小于200 GiB。

- 公网IP:选中分配公网IPv4地址,带宽计费方式选择按使用流量,带宽峰值选择100 Mbps,以加快模型下载速度。

3、添加安全组规则。

在云服务器实例安全组的入方向添加安全组规则并放行7860端口。

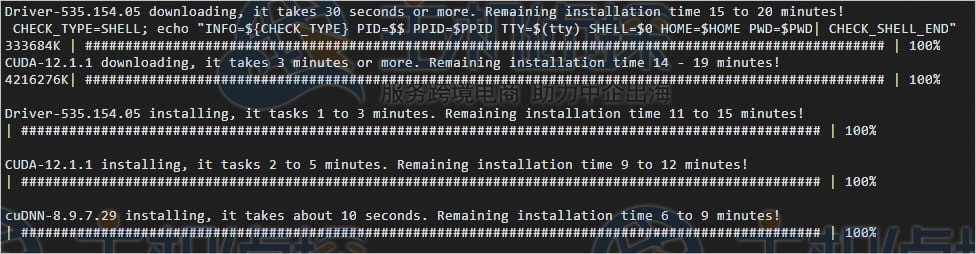

4、查看驱动以及CUDA库是否安装成功。

a.使用root用户远程登录云服务器实例。

首次登录ECS实例时,系统会自动安装驱动。当显示如下图所示的回显信息时,表示驱动以及CUDA库已安装成功。

b.再次使用root用户远程登录ECS实例。具体操作,请参见使用Workbench工具以SSH协议登录Linux实例。

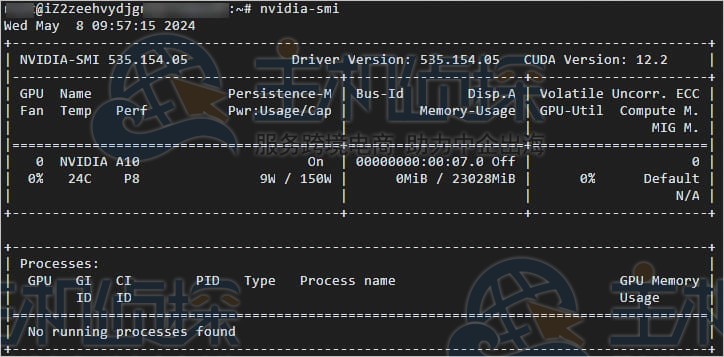

c.执行以下命令,查看GPU驱动的版本。

nvidia-smi

回显信息类似下图所示。

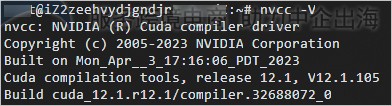

d.执行以下命令,查看CUDA库的版本。

nvcc -V

回显信息如下图所示。

1、安装Python 3.11并升级pip。

a.分别执行以命令,安装Python 3.11。

apt-get update

apt-get upgrade

apt install -y python-is-python3 # 将默认Python改成Python3

apt install -y software-properties-common # 安装software-properties-common软件包

add-apt-repository ppa:deadsnakes/ppa # 添加PPA存储库

apt -y install python3.11 # 安装Python 3.11

update-alternatives --install /usr/bin/python3 python3 /usr/bin/python3.11 1 # 设置默认Python为Python 3.11

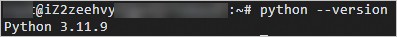

b.执行如下命令,查看Python版本。

python --version

当回显如下所示时,表示已安装Python 3.11.9。

c.分别执行以命令,升级pip。

wget https://bootstrap.pypa.io/get-pip.py

python3.11 get-pip.py

2、执行以下命令,安装Git和Git LFS软件。

apt install -y git git-lfs python3.11-distutils

3、依次执行以下命令,安装模型所需要的Python包。

sudo apt-get install pkg-config cmake

sudo apt-get install python3.11-dev

pip install git+https://github.com/huggingface/transformers

pip install sentencepiece==0.1.97 -i https://mirrors.aliyun.com/pypi/simple

pip install peft==0.10.0 -i https://mirrors.aliyun.com/pypi/simple

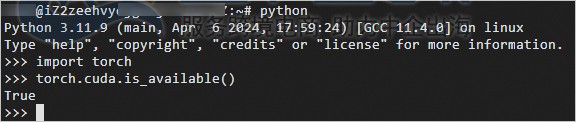

4、在PyTorch环境下验证GPU是否正常工作。

a.执行以下命令,进入Python运行环境。

python

b.执行以下命令,验证GPU是否正常工作。

import torch

torch.cuda.is_available()

返回True,表示GPU正常工作。

c.执行以下命令,退出Python。

quit()

5、依次执行以下命令,下载tmux并创建一个tmux session。

apt install -y tmux

tmux

6、执行以下命令,下载Chinese-LLaMA-Alpaca模型。

git clone https://github.com/ymcui/Chinese-LLaMA-Alpaca.git

7、执行以下命令,下载chinese-alpaca-lora-13b模型。

git clone https://www.modelscope.cn/ChineseAlpacaGroup/chinese-alpaca-lora-13b.git

8、依次执行以下命令,下载llama-13b-hf。

llama-13b-hf是预训练的llama 13b模型,已经转换成了Huggingface的模型格式。

pip install -U huggingface_hub

pip install -U hf-transfer

export HF_ENDPOINT=https://hf-mirror.com

export HF_HUB_ENABLE_HF_TRANSFER=1

huggingface-cli download --resume-download --local-dir-use-symlinks False yahma/llama-13b-hf --local-dir llama-13b-hf

9、依次执行以下命令,合并代码。

cd Chinese-LLaMA-Alpaca/

python scripts/merge_llama_with_chinese_lora.py --base_model ~/llama-13b-hf/ \

--lora_model ~/chinese-alpaca-lora-13b/ --output_type huggingface \

--output_dir ./llama_with_lora_hf

命令行中需要用–output_dir命令指定一个输出目录,本示例中输出目录为/root/Chinese-LLaMA-Alpaca/llama_with_lora_hf。转换需要一段时间,需要耐心等待。

10、执行以下命令,查看转换完成后的文件。

ls -lh llama_with_lora_hf

1、执行以下命令,在/root目录或者您的工作目录,下载WebUI并且进行代码部署。

cd

git clone https://github.com/oobabooga/text-generation-webui.git

2、执行以下命令,安装代码及依赖库。

cd text-generation-webui/

pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple

pip install datasets gradio rich bitsandbytes -i https://mirrors.aliyun.com/pypi/simple/

3、执行以下命令,在models目录下面生成一个软链接,指向合并后模型数据的目录。

ln -s /root/Chinese-LLaMA-Alpaca/llama_with_lora_hf/ models/llama_with_lora_hf

参数说明如下:

- /root/Chinese-LLaMA-Alpaca/llama_with_lora_hf/:指的是合并模型存放的目录。

- models/llama_with_lora_hf:指的是模型名称,用户可以修改成其他名称。

完成以上操作后,用户已经成功完成了WebUI部署和个人对话大模型的搭建。

(本文由美国主机侦探原创,转载请注明出处“美国主机侦探”和原文地址!)

微信扫码加好友进群

主机优惠码及时掌握

QQ群号:938255063

主机优惠发布与交流