虽然在GPU或AI芯片上部署DeepSeek-R1及其蒸馏模型,可以获得最佳的延迟和吞吐量表现,但并非所有应用场景都需要如此高的性能。在某些情况下,将这些模型部署在CPU上可能具有更好的性价比。本文将主要介绍基于亚马逊云科技免费云服务器——Amazon EC2实例,使用Ollama和Ollama Web UI部署DeepSeek-R1蒸馏模型。

一、免费使用Amazon EC2示例

Amazon EC2(弹性计算云)是亚马逊云计算服务平台(AWS)提供的一项云服务器产品,目前对新客户开放免费试用12个月权益。Amazon EC2在云端运行虚拟服务器(称为实例),并且可以根据需要灵活扩展计算能力。大家在选择时可以根据需求选择不同类型的实例、配置和操作系统,以支持各种应用程序、从简单的网页托管到大规模的企业级计算。

亚马逊云科技官网:点击访问(免费试用12个月Amazon EC2)

Amazon EC2免费实例规格:

- 性能可突增的CPU

- 1核1GB内存

- 30GB SSD

- 每月750个小时的Linux、RHEL或SLES t2.micro或t3.micro实例使用时间

- 每月750个小时的Windows t2.micro或t3.micro实例使用时间

- 每月750小时无实例类型限制的公有IPv4地址使用时间

- 多操作系统可选

(1)找到控制台并创建角色

登录亚马逊云科技管理控制台,导航到Amazon IAM页面,点击“创建角色”。受信任的实体类型选择Amazon Web Services,用例选择Amazon EC2。

注意:此步骤采用了较宽松的Amazon IAM托管策略,仅用于沙盒账户简化演示。在实际工作负载中,即便是非生产环境,也务必遵循最小权限原则。

(2)附加策略并创建角色

将AmazonS3FullAccess和AmazonSSMManagedInstanceCore这两个托管策略附加到deepseek – r1角色上,然后点击“创建角色”,完成Amazon IAM实例配置文件创建的第一部分。

(1)启动实例

打开亚马逊云科技管理控制台,导航至Amazon EC2页面,按以下规格启动一个Amazon EC2实例:

(a)AMI:选择Amazon Linux 2 AMI;

(b)实例类型:选择 g4dn.xlarge;

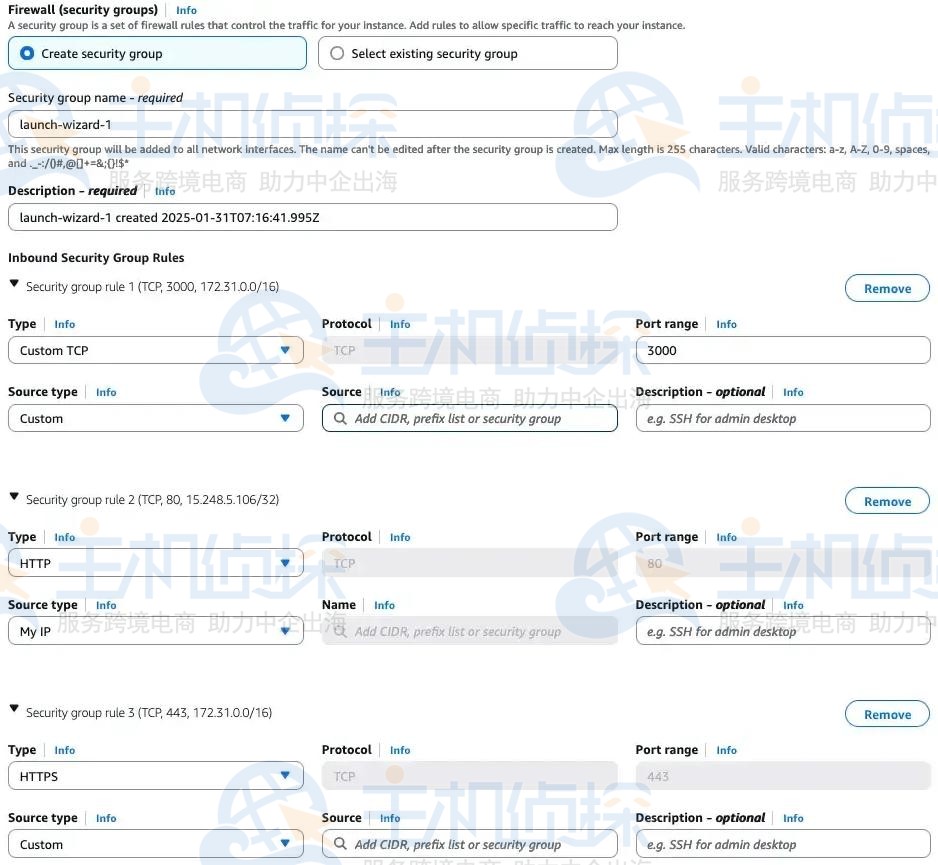

(c)网络设置:点击“编辑”,使用默认的VPC设置。创建一个新的安全组,并设置入站规则如下:

- 允许来自“My IP”的HTTP流量;

- 允许来自VPC CIDR范围、目标端口为3000的TCP流量(此为后续部署应用程序负载均衡器时流量转发到Amazon EC2实例的必要条件);

- 允许来自VPC CIDR范围的HTTPS流量。

(d)配置存储:设置为100GiB gp3。

(e)高级详情:Amazon IAM实例配置文件选择deepseek – r1。

(2)连接实例

实例启动完成后,选择deepseek – r1,在“会话管理器”(Session Manager)选项卡下点击“连接”,后续使用此SSM建立的终端执行部署操作。

在会话管理器终端中按顺序执行以下命令:

sudo yum update -y

sudo yum install gcc make

sudo yum install -y gcc kernel – devel – $(uname – r)

cd ~

aws s3 cp –recursive s3://ec2 – linux – nvidia – drivers/latest/ .

chmod +x NVIDIA – Linux – x86_64*.run

mkdir /home/ssm – user/tmp

chmod -R 777 tmp

cd /home/ssm – user

export TMPDIR=/home/ssm – user/tmp

CC=/usr/bin/gcc10 – cc ./NVIDIA – Linux – x86_64*.run –tmpdir=$TMPDIR

按照屏幕提示完成驱动程序安装,选择默认配置选项。安装中若出现警告,确认后继续安装。安装完成后,验证驱动程序是否正确安装,并禁用GSP(GPU Safety Package):

2、安装并配置Dockernvidia – smi – q | head

sudo touch /etc/modprobe.d/nvidia.conf

echo “options nvidia NVreg_EnableGpuFirmware=0” | sudo tee –append /etc/modprobe.d/nvidia.conf

在会话管理器终端运行以下命令安装并启动 Docker:

sudo yum install docker

sudo usermod -a -G docker ec2 – user

sudo systemctl enable docker.service

sudo systemctl start docker.service

启动 Docker 服务后,运行以下命令使用 NVIDIA 驱动程序配置 Docker:

3、安装并配置Ollama服务器和Ollama Web UIcurl -s -L https://nvidia.github.io/libnvidia – container/stable/rpm/nvidia – container – toolkit.repo | \

sudo tee /etc/yum.repos.d/nvidia – container – toolkit.repo

sudo yum install -y nvidia – container – toolkit

sudo nvidia – ctk runtime configure –runtime=docker

sudo systemctl restart docker

运行以下命令部署 Ollama 服务器,并验证其可访问性:

docker run -d –gpus=all -v ollama:/root/.ollama -p 11434:11434 –name ollama –restart always ollama/ollama

curl localhost:11434

Ollama服务器运行后,从 Ollama库中拉取DeepSeek – R1 – Distill – Qwen – 14B模型:

docker exec -it ollama ollama pull deepseek – r1:14b

最后,设置Ollama Web UI,以便用户通过网络浏览器与模型交互:

四、配置应用程序负载均衡器 1、创建应用程序负载均衡器docker run -d -p 3000:8080 –add – host=host.docker.internal:host – gateway -v ollama – webui:/app/backend/data –name ollama – webui –restart always ghcr.io/ollama – webui/ollama – webui:main

在亚马逊云科技管理控制台中,导航到Amazon EC2页面,在左侧导航栏选择“负载均衡器”,选择“应用程序负载均衡器”(ALB),点击“创建”。

2、配置ALB(1)方案:选择面向互联网。

(2)负载均衡器IP地址类型:选择IPv4。

(3)网络设置:选择默认的VPC设置,并选择Amazon EC2实例所在的可用区。

(4)安全组:选择在Amazon EC2配置步骤中创建的安全组。

在“监听器和路由”部分,使用默认的HTTP:80设置,点击“创建目标组”。

(1)目标类型:指定为“实例”。

(2)目标组命名:命名为deepseek – tg,点击“下一步”。

注册目标:将deepseek – r1实例注册为目标,指定端口为3000,点击“标记为待处理并包含”,然后点击“创建目标组”。

返回到应用负载均衡器创建页面,选择deepseek – tg目标组,向下滚动并点击“创建负载均衡器”。

在亚马逊云科技管理控制台中,导航到Amazon EC2页面,在左侧导航栏选择“负载均衡器”,选择之前创建的deepseek – alb,获取其DNS名称。

使用网络浏览器访问该DNS名称,会看到一个注册页面。

使用电子邮件地址和密码进行注册,即可开始探索部署在Amazon EC2上的DeepSeek – R1 – Distill – Qwen – 14B模型,该模型通过Ollama和Ollama Web UI提供服务。

相关推荐:

《Amazon EKS上部署DeepSeek-R1模型教程》

(本文由美国主机侦探原创,转载请注明出处“美国主机侦探”和原文地址!)

微信扫码加好友进群

主机优惠码及时掌握

QQ群号:938255063

主机优惠发布与交流