如何使用GPU服务器实现最大计算速度?首先商家应该了解GPU服务器的概念及其关键组件,之后通过选择合适的GPU类型、配置GPU服务器、安装操作系统、网络配置等可实现GPU服务器的设置,最后则需要对GPU服务器进行性能优化和监控维护。

在技术飞速发展的时代,GPU服务器已成为企业和研究人员不可或缺的工具。从深度学习和 AI 训练到渲染和科学模拟,GPU服务器提供了高效处理这些要求苛刻的任务所需的计算能力。本文将引导用户了解GPU服务器的有关概况,确保在IT环境中最大限度地发挥其潜力。

一、了解GPU服务器

GPU(图形处理单元)服务器是将一个或多个 GPU 与传统 CPU 相结合的服务器。与专为通用处理而设计的 CPU 不同,GPU 在并行处理方面表现出色,使其成为需要大量计算的任务的理想选择,例如机器学习、数据分析和视频渲染。对于具有特定要求的企业,定制服务器提供量身定制的解决方案来优化性能和效率。

推荐阅读:《GPU服务器与CPU服务器的区别有哪些?GPU服务器与CPU服务器对比》

GPU服务器的关键组件

- 图形处理器 (GPU):核心组件,负责并行处理和处理密集型计算任务。

- 中央处理器:与 GPU 协同工作,管理常规处理并将任务委派给 GPU。

- 内存 (RAM):对于在处理任务时临时存储数据至关重要。

- 存储:首选高速 SSD,以确保快速访问大型数据集。

- 冷却系统:管理 GPU 产生的热量是必要的,尤其是在重负载下。

设置GPU服务器需要仔细考虑几个关键因素,以确保服务器针对现有任务进行了优化,从选择合适的GPU到配置服务器和网络,每个步骤对于实现最佳性能都至关重要。

1、选择合适的GPU选择合适的GPU是设置GPU服务器时最关键的决策,因为它直接影响服务器处理特定工作负载的能力,请考虑以下因素:

(1)工作负载类型

- AI 和深度学习:对于神经网络训练等任务,具有高计算性能的 GPU,如 NVIDIA 的 A100 系列是理想的选择,这些 GPU 提供大量 CUDA 核心和 Tensor 核心,可加速训练过程并允许高效处理大型数据集。

- 渲染和 3D 建模:对于渲染任务,最好使用具有高内存带宽和强大支持光线追踪的 GPU,例如 NVIDIA Quadro RTX 系列,这些 GPU 旨在高效管理复杂的 3D 模型和渲染管道。

- 数据分析和科学计算:在内存容量和处理能力之间提供平衡的 GPU,如 NVIDIA Tesla 系列是理想的选择,这些 GPU 擅长处理并行处理任务和大型数据数组。其中RAKsmart美国GPU服务器提供NVIDIA Tesla驱动的计算实例,可有效满足用户密集型工作任务的需求。

-

方案 GPU 内存 SSD 宽带 流量 价格/月 购买链接 E5 – 2698v4*2 NVIDIA Tesla P100 16G*8 1024G 2*1T 100M 不限 4329 立即购买 E5 – 2698v4*2 NVIDIA Tesla V100 16G*4 768G 2*1T 100M 不限 4550 立即购买 E5-2680v4*2 NVIDIA Tesla V100 16G*8 512G 512GB 10G 可选 9519 立即购买

(2)GPU数量

- 单个 GPU 与多个 GPU:使用单个 GPU 还是多个 GPU 的决定取决于工作负载的规模,多 GPU 设置有利于大规模深度学习模型、高性能计算 (HPC) 和渲染场,因为它们允许分布式处理,从而减少整体计算时间。

- 可扩展性:如果考虑未来的可扩展性,请选择支持额外 GPU 的服务器机箱和主板,确保服务器可以根据工作负载需求进行扩展,一些服务器可以支持多达 8 个或更多 GPU,从而提供强大的计算能力。

(3)特定型号

- NVIDIA A100:A100 以其在 AI 和 HPC 工作负载中的性能而闻名,是一款多功能 GPU,可提供高内存带宽和针对深度学习优化的 Tensor 核心。

- NVIDIA Quadro RTX:该系列是创意专业人士的理想选择,得益于其实时光线追踪和 AI 增强的工作流程,该系列在渲染、3D 建模和内容创建任务方面表现出色,例如Linode提供由NVIDIA Quadro RTX 6000 加速的GPU服务器,这些GPU服务器利用 CUDA、Tensor 和 RT 核心的力量来执行复杂的处理、转码和光线追踪工作负载。

-

方案 内存 CPU 硬盘 流量 入带宽 出带宽 GPU 价格 RTX6000 GPU x1 32 GB 8核 640 GB SSD 16 TB 40 Gbps 10 Gbps 1 $1000 / mo ($1.5 / hr) RTX6000 GPU x2 64 GB 16核 1280 GB SSD 20 TB 40 Gbps 10 Gbps 2 $2000 / mo ($3 / hr) RTX6000 GPU x3 96 GB 20核 1920 GB SSD 20 TB 40 Gbps 10 Gbps 3 $3000 / mo ($4.5 / hr) RTX6000 GPU x4 128 GB 24核 2560 GB SSD 20 TB 40 Gbps 10 Gbps 4 $4000 / mo ($6 / hr) - AMD Radeon Instinct:对于那些正在寻找 NVIDIA 替代品的人来说,AMD 的 Radeon Instinct 系列在机器学习和 HPC 任务中提供了有竞争力的性能,并提供了对开源机器学习库的强大支持。

选择适当的 GPU 后,下一步是配置服务器以补充GPU功能:

(1)CPU选择

- 兼容性:选择与 GPU 互补的 CPU,确保它能够处理 GPU 所需的数据吞吐量。Intel Xeon 或 AMD EPYC 系列的高内核数 CPU 通常是多 GPU 设置的首选,因为它们可以防止并行处理过程中出现瓶颈。

- 任务要求:对于 AI 和机器学习任务,具有高单线程性能的 CPU 在数据预处理阶段可能很有用。对于涉及多任务处理或需要处理大量并发线程的工作负载,具有更多内核的 CPU 可能是有利的。

(2)内存 (RAM)

- 容量:确保有足够的 RAM 来处理正在处理的数据。对于深度学习和大规模模拟,建议至少使用 64GB RAM,但对于非常大的数据集,可能需要 128GB 或更高。

- 速度:选择高速 RAM(DDR4 或 DDR5)以满足 CPU 和 GPU 的需求。更快的 RAM 可以减少延迟并提高整体系统性能,尤其是在内存密集型任务中。

(3)存储解决方案

- 高速 SSD:固态硬盘 (SSD) 因其高读/写速度而受到青睐,这在处理大型数据集或需要快速数据访问时至关重要。特别是 NVMe SSD,与传统 SATA SSD 相比,数据传输速率明显更快。

- 数据冗余和备份:考虑实施 RAID 配置以实现数据冗余和备份,尤其是在GPU服务器处理关键数据时,RAID 5 或 RAID 10 设置可以在性能和数据保护之间提供平衡。

(4)冷却解决方案

- 主动冷却:GPU 会产生大量热量,尤其是在重负载下,高性能风扇和散热器对于保持最佳温度和防止热节流至关重要。

- 液体冷却:对于多 GPU 设置或空间有限的环境,液体冷却系统可提供高效的散热,即使在密集的工作负载下也有助于保持稳定的温度。

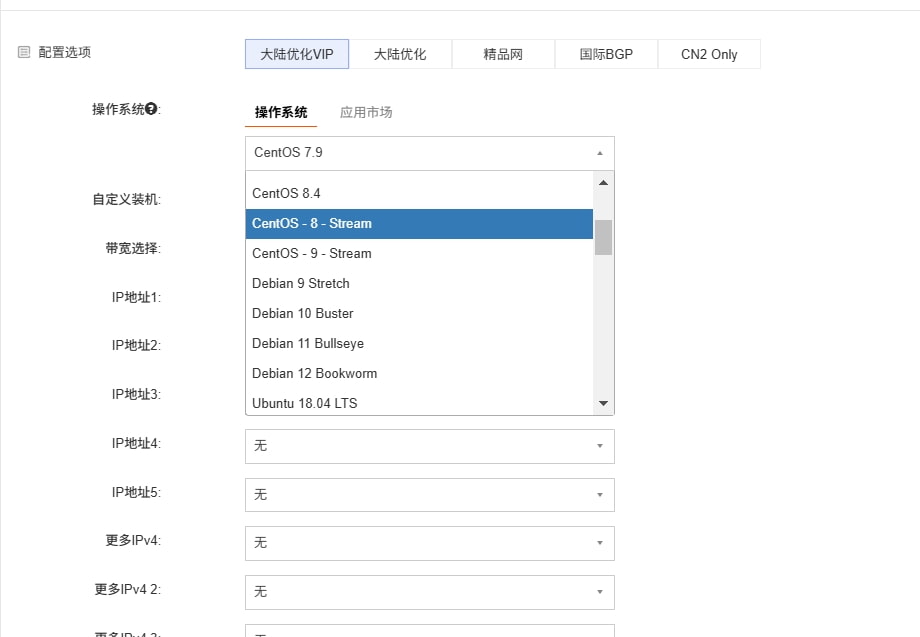

操作系统 (OS) 在有效管理 GPU 服务器方面起着关键作用,选择的操作系统应支持 GPU 驱动程序和计划运行的特定应用程序:

(1)Linux 发行版

- Ubuntu:由于其易用性、广泛的社区支持以及与 NVIDIA CUDA 等 GPU 驱动程序的强大兼容性,许多人都喜欢它。Ubuntu 还为 TensorFlow 和 PyTorch 等机器学习框架提供了广泛的支持。

- CentOS/Red Hat Enterprise Linux (RHEL):CentOS 和 RHEL 因其稳定性和长期支持而在企业环境中受到青睐,非常适合需要高可靠性和安全性的生产系统,它们还对 GPU 驱动程序和科学计算库提供强大的支持。

(2)Windows

Windows Server:Windows Server 最适合已集成到 Windows 环境中的组织,它为 GPU 加速应用程序(如 Autodesk Maya)和某些与 Windows作系统兼容的机器学习框架提供强大的支持。

4、GPU服务器网络配置正确的网络配置对于将 GPU 服务器集成到现有 IT 基础设施中至关重要,尤其是在服务器将被远程访问或将处理大量数据传输时:

(1)IP 地址配置

- 静态 IP 地址:为 GPU 服务器分配静态 IP 地址可以简化网络管理,尤其是在服务器由多个用户访问或与其他系统集成的环境中。

- DNS 配置:确保服务器已正确配置 DNS 服务器,以便在网络中正确解析名称。

(2)用于远程管理的 SSH 访问

- SSH 设置:配置 SSH (Secure Shell) 以远程管理 GPU 服务器。SSH 允许从远程位置安全地连接到服务器,能够管理任务、监控性能和执行维护,而无需对服务器进行物理访问。

- 基于密钥的身份验证:为了增强安全性,请设置基于 SSH 密钥的身份验证,而不是基于密码的登录,这降低了未经授权访问服务器的风险。

(3)高带宽连接

- 网络接口卡 (NIC):安装高速 NIC 以确保 GPU 服务器能够有效地处理大量数据传输。对于需要高吞吐量的环境,建议使用 10GbE(10 Gb 以太网)或更高的 NIC。

- 存储网络集成:如果服务器需要访问网络连接存储 (NAS) 或存储区域网络 (SAN),请确保网络配置支持高带宽和低延迟连接。这对于用于数据密集型应用程序(如视频渲染或科学模拟)的 GPU 服务器尤其重要。

通过在设置过程中仔细考虑这些因素中的每一个,可以确保 GPU 服务器能够很好地处理工作负载的特定需求,从而为任务提供所需的性能和可靠性。

三、GPU服务器性能优化 1、定期更新GP 驱动程序和库(1)驱动程序更新

使 GPU 驱动程序保持最新状态对于确保与最新软件的兼容性和利用性能增强功能至关重要。NVIDIA 等制造商会定期发布驱动程序更新,以优化 TensorFlow、PyTorch 和渲染软件等新版本应用程序的性能。

(2)库更新

与驱动程序类似,更新您的软件库(例如 cuDNN、CUDA Toolkit)可确保您使用最有效的可用版本。这些更新通常包括新功能、优化和错误修复,可以提高 GPU 加速应用程序的性能。

2、跨多个GPU的负载均衡(1)工作负载分配

在具有多个 GPU 的环境中,均匀分配工作负载对于最大限度地提高计算效率至关重要。负载平衡可防止任何单个 GPU 成为瓶颈,从而导致硬件资源利用率不足。可以采用数据并行等技术,其中大型数据集被拆分到多个 GPU 上,以实现平衡的工作负载分配。

(2)多 GPU 配置

TensorFlow 和 PyTorch 等框架支持多 GPU 配置,允许水平扩展计算。这在深度学习模型训练等任务中特别有用,因为在深度学习模型训练中,工作负载可以分配到多个 GPU 以减少训练时间。

3、考虑超频GPU(1)超频

对于希望将 GPU 推向极限的高级用户,超频是一种选择。超频涉及以高于默认设置的速度运行 GPU,这可能会导致某些任务的性能提升。但是应谨慎执行此作,因为它会增加热量输出和功耗,可能导致系统不稳定或硬件寿命缩短。

(2)冷却解决方案

如果超频,请确保冷却系统足以处理增加的热负荷。建议使用高性能冷却系统(包括液体冷却或高级空气冷却设置),以保持稳定的温度并避免热节流。

4、分析和优化(1)性能分析

NVIDIA 的 Nsight Systems 和 Nsight Compute 等工具可用于分析GPU应用程序,从而深入了解瓶颈和效率低下的情况。通过识别应用程序的哪些部分没有充分利用GPU,您可以进行有针对性的优化以提高性能。

(2)内存管理

高效的内存使用是最大限度地提高GPU性能的关键。确保应用程序有效地管理GPU内存,避免 CPU 和 GPU 之间过多的内存传输,这可能会减慢处理速度,内存池和预取等技术有助于优化内存管理。

通过遵循这些最佳实践,可以确保GPU服务器以最高效率运行,从而提供最苛刻的应用程序所需的计算能力。

四、GPU服务器监控和维护维护GPU服务器的运行状况和性能对于确保长期可靠性和效率至关重要。适当的监控和日常维护可以防止代价高昂的停机时间并延长硬件的使用寿命。

1、监控工具nvidia-smi (System Management Interface):这是 NVIDIA 提供的命令行工具,对于监控和管理 NVIDIA GPU 至关重要。它提供对 GPU 性能各个方面的实时洞察,包括:

- GPU 利用率:跟踪当前正在使用的GPU资源的百分比,帮助确定您的应用程序是否充分利用了GPU的功能。

- 温度监控:监控每个GPU的工作温度,使您能够在潜在过热问题造成损坏或限制之前检测并解决它们。

- 内存使用情况:提供有关GPU内存使用情况的详细信息,包括总内存、已用内存和可用内存,这对于确保应用程序有效利用GPU资源至关重要。

- 功耗:跟踪GPU服务器的功耗,帮助您管理电源效率并识别可能表明存在问题的任何异常功耗。

日常维护对于保持GPU服务器平稳运行和防止硬件故障至关重要,以下是应定期执行的详细维护任务:

(1)除尘

GPU服务器内部积聚的灰尘会导致过热,从而降低性能并可能导致硬件损坏。定期清理服务器的内部结构至关重要,包括:

- 风扇和散热器:灰尘会堵塞风扇和散热器,从而削弱其散热能力。使用压缩空气吹出这些组件中的灰尘,确保它们高效运行。

- 空气过滤器:如果您的服务器有空气过滤器,请定期清洁或更换它们以保持最佳气流。

- PCB 和电源:轻轻清除服务器印刷电路板 (PCB) 和电源上的灰尘,以防止电气短路或过热。

(2)驱动程序更新

使GPU服务器驱动程序保持最新状态对于保持与最新软件的兼容性和实现最佳性能至关重要。更新的驱动程序通常包括:

- 性能增强:新驱动程序可以通过优化GPU服务器处理某些任务的方式来提高 GPU 性能,从而缩短处理时间并提高整体效率。

- 错误修复:驱动程序更新解决了可能影响 GPU 稳定性或性能的已知问题,从而降低了崩溃或其他问题的可能性。

- 新功能:更新还可能引入可以增强 GPU功能的新功能,例如支持新 API 或改进对 CUDA 和 cuDNN 等现有软件库的支持。

(3)硬件检查

冷却系统检查:定期检查冷却系统以确保其正常运行,这包括:

- 风扇:验证所有风扇是否都在自由旋转而没有任何障碍物,并且为 GPU 和 CPU 等关键组件提供足够的气流。

- 导热膏:随着时间的推移,GPU/CPU 和散热器之间的导热膏会变干,从而降低其有效性。如有必要,请重新涂抹导热膏以保持最佳传热。

- 液体冷却:如果服务器使用液体冷却,请检查是否有泄漏并确保冷却剂液位充足,此外也许检查泵和散热器是否正常运行。

电源和连接:确保电源为 GPU 和其他组件提供稳定的电源。检查所有电源连接是否有磨损、腐蚀或损坏的迹象。

硬件完整性:定期检查 GPU、主板和其他组件是否有物理损坏或磨损迹象,例如连接器烧毁或电容器膨胀。及早发现此类问题可以防止灾难性故障。

为了保持领先地位,请考虑采用灵活且可扩展的GPU服务器基础设施,以便在新技术可用时轻松集成它们,探索最新的GPU服务器解决方案可以提高竞争优势。如果用户想要拥有更多GPU类型的选择,建议点击访问Vultr官网,Vultr为商家提供了包括NVIDIA A100、AMD Instinct等八种GPU型号。

有关GPU服务器价格和应用场景的进一步指导,请务必阅读《GPU服务器有什么用?GPU服务器常见应用场景介绍》和《GPU服务器租用收费标准》的详细文章以获得更多见解。

(本文由美国主机侦探原创,转载请注明出处“美国主机侦探”和原文地址!)

微信扫码加好友进群

主机优惠码及时掌握

QQ群号:938255063

主机优惠发布与交流