随着人工智能的发展,人们已经可以使用工具来部署本地化服务,n8n、Ollama和DeepSeek都是现阶段比较热门且实用的工具,借助它们用户可以实现在本地部署个人AI智能体,本文就来详细带大家来了解下,教程仅供参考。

一、安装n8n+Ollama+DeepSeek

借助n8n+DeepSeek+Ollama,用户可以在本地部署个人AI智能体。要实现这一操作,首选需要有一个合适的服务器,建议选择16GB显存GPU Windows服务器,本文推荐HostEase GPU服务器。

1、下载适用于Windows系统的Ollama,安装完成后,在Windows桌面右键点击,就能打开命令行界面(CLI)。当菜单出现时,选择“在终端中打开”。

在命令行界面中,输入以下指令:

ollama run deepseek-r1:8b

上述指令会通过Ollama完成DeepSeek-R1的安装与运行。

ollama list

2、安装Docker Desktop

接下来,用户需要为Windows系统安装Docker Desktop。

安装过程中,系统会提示用户选择使用WSL 2还是Hyper-V,建议选择WSL 2。

3、在Windows系统上安装好Docker Desktop后,就可以安装n8n并搭配Docker使用。

确保Docker Desktop软件处于运行状态,接着在命令行界面中输入以下两条指令:

docker volume create n8n data

docker run -it –nm –name n8n -p 5678:5678 -v n8n-data:/home/node/.n8n docker.n8n.io/n8nio/n8n

这些指令会完成以下操作:

创建名为n8n_data的持久存储(卷)

生成名为n8n的Docker容器和镜像

当第二条指令执行完毕,用户应该会看到这样一条提示信息:

Editor is now accessible via:

http://localhost:5678/

4、打开网络浏览器,访问localhost:5678。

这时,用户会看到n8n的注册表单。填写表单,创建用于登录n8n服务器的凭证,这些凭证同时也用于登录n8n的网页账户。

记得获取免费的许可证密钥。

完成注册后,用户会看到一个空白的工作流程画布,如下所示:

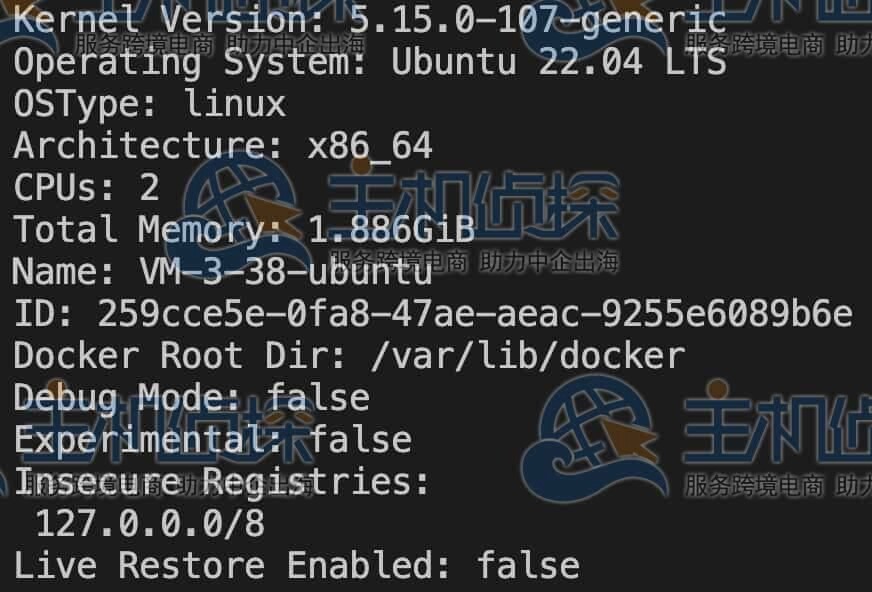

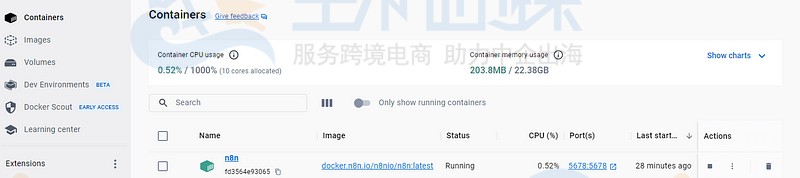

在Docker Desktop中,用户看到的内容大概如下:

5、使用上文提到的命令从CLI运行n8n:

docker run -it –rm –name n8n -p 5678:5678 -v n8n_data:/home/node/.n8n docker.n8n.io/n8nio/n8n

访问localhost:5678,这时用户应该会看到n8n的登录界面了。

相关推荐:《适合n8n工作流的五大国外VPS商家推荐》

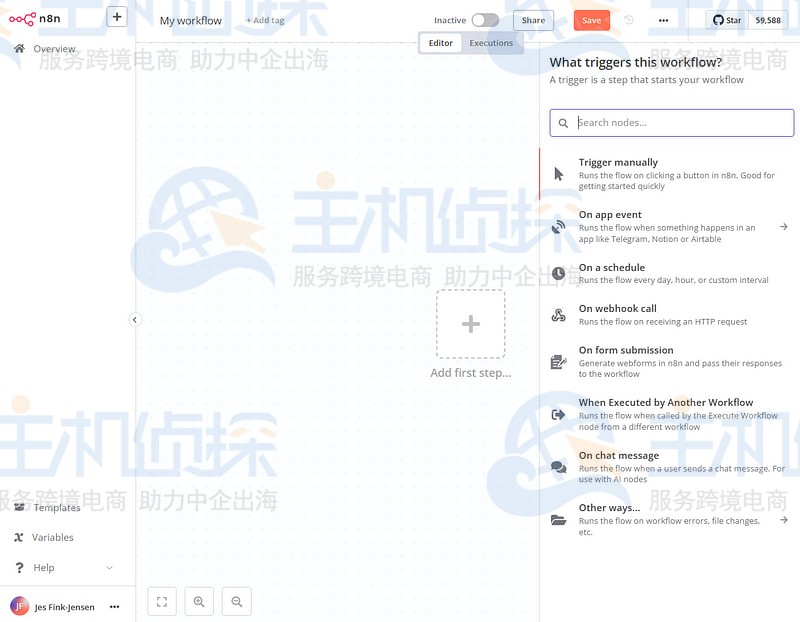

二、在n8n中创建个人AI智能体1、登录n8n后,你会看到一个标题为“My workflow”的空白工作区。

2、在屏幕正中间,有个加号。点击它,右侧会弹出如下菜单:

3、选择“On chat message”,然后点击“Back to canvas”。此时,画布中央会出现一个新节点:

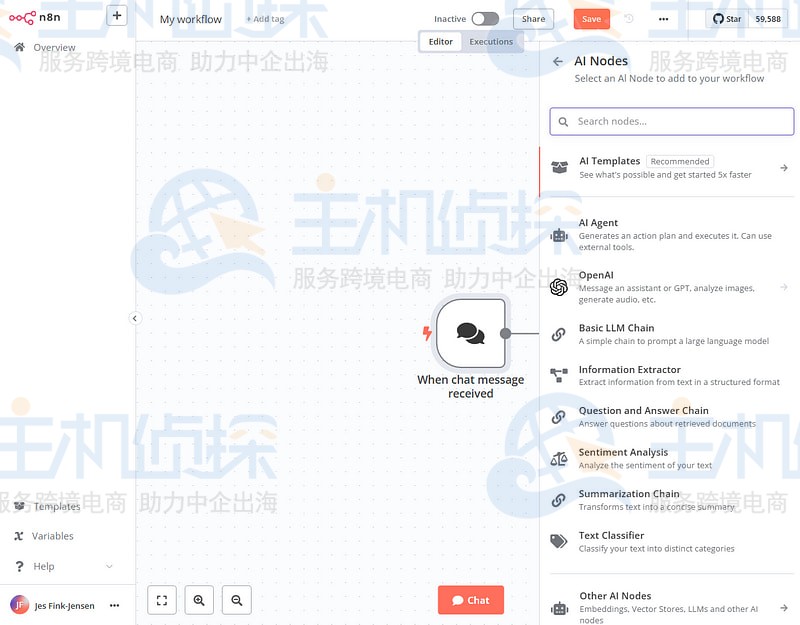

4、点击该节点右侧的加号,选择“Advanced AI”:

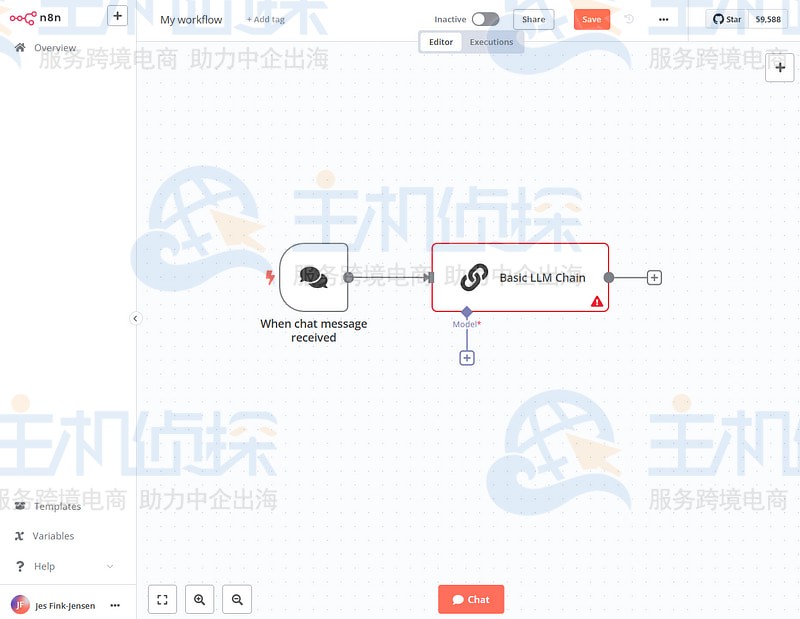

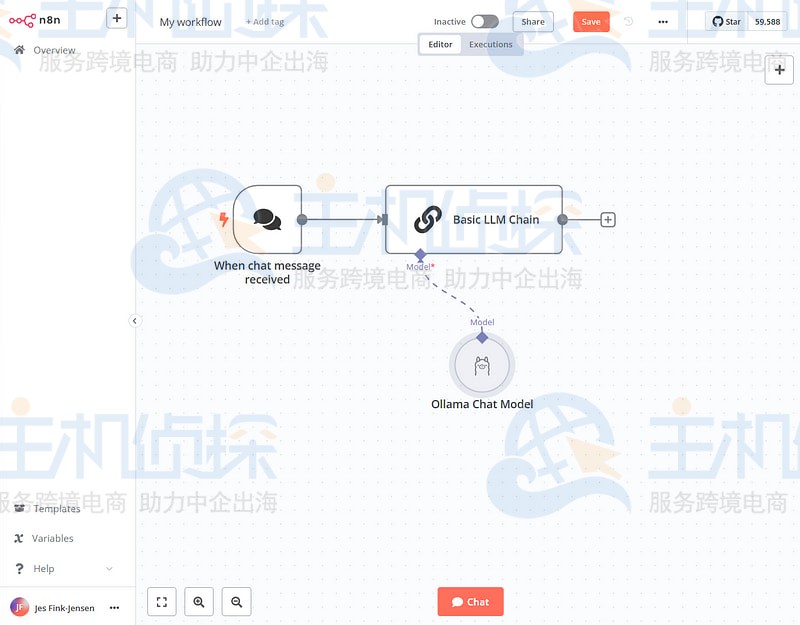

5、选择“Basic LLM Chain”,再次点击“Back to canvas”。用户会看到如下内容:

6、点击“Basic LLM Chain”节点下方的加号:

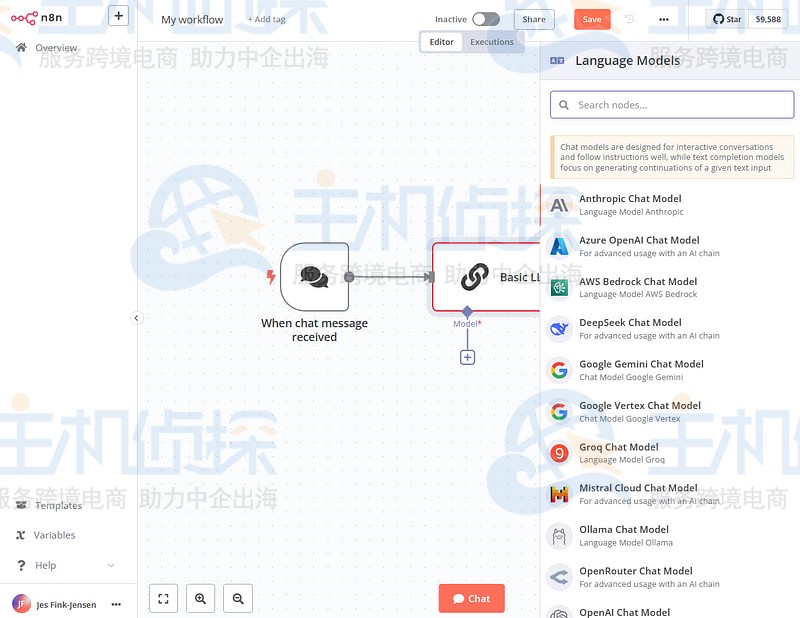

7、选择“Ollama Chat Model”:

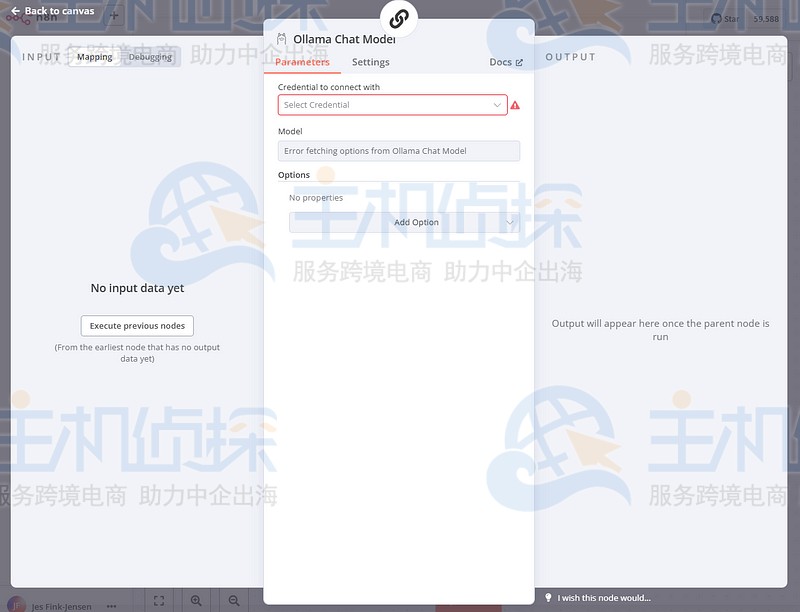

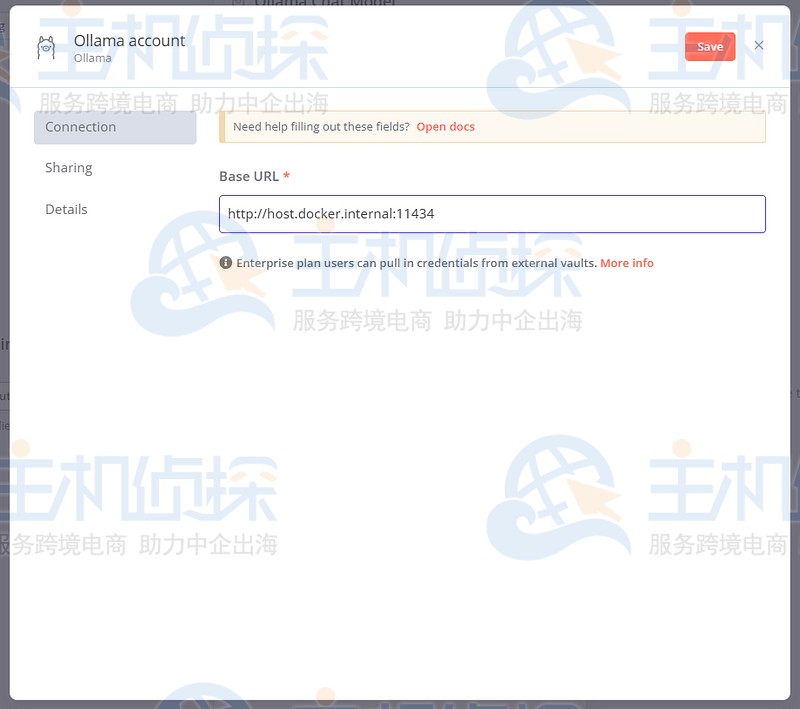

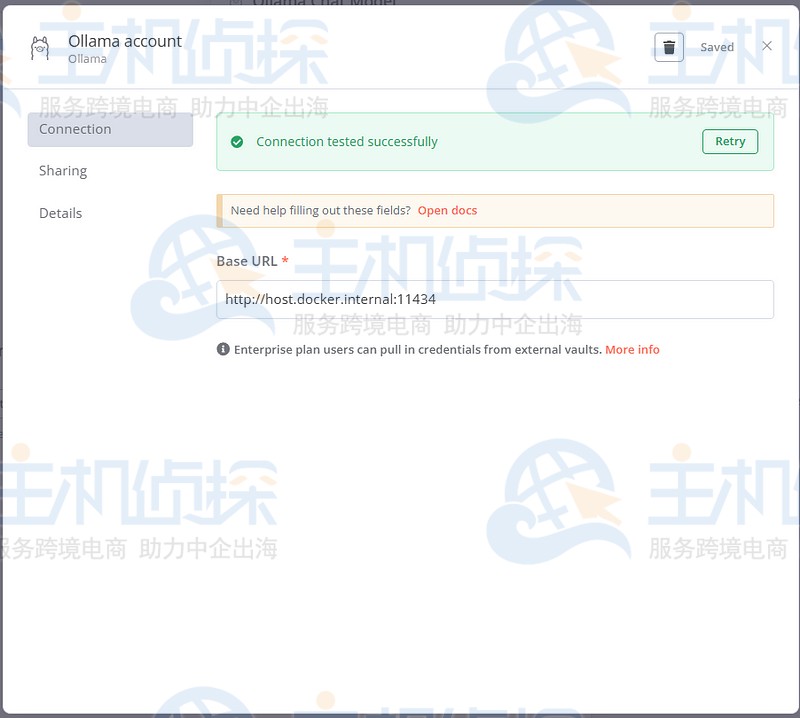

8、点击“Select Credential”,接着点击“Create new credential”。按照下面的示例填写对话框:

注:用户需要把基本URL设置为http://host.docker.internal:11434。

9、填完点击“保存”。这时会出现一条绿色提示消息“Connection tested successfully”。

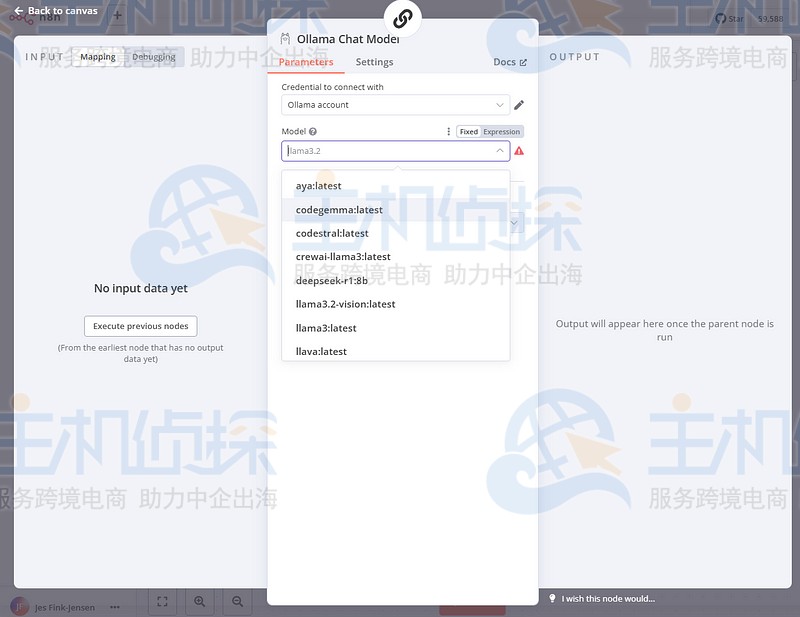

10、点击右上角的叉号。现在,用户可以从下拉列表中挑选想用的大语言模型,本文选择的是DeepSeek-R1。

再次回到画布,会看到以下内容:

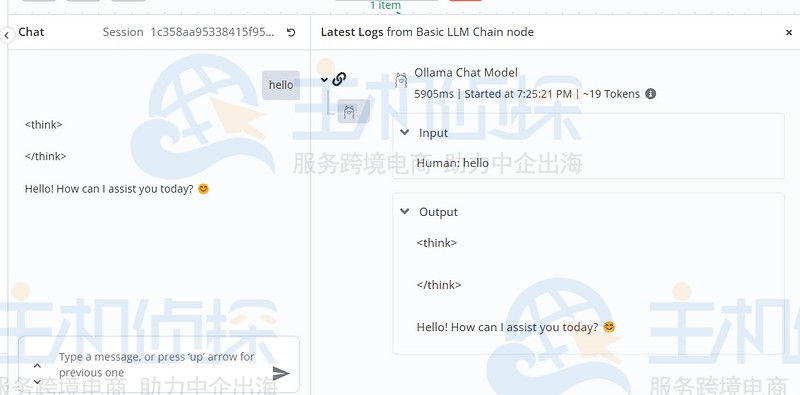

11、点击底部的“Chat”,输入“Hello”,用户应该会收到如下回复:

接下来,用户就可以和DeepSeek-R1进行聊天了。

(本文由美国主机侦探原创,转载请注明出处“美国主机侦探”和原文地址!)

微信扫码加好友进群

主机优惠码及时掌握

QQ群号:938255063

主机优惠发布与交流